Yapay Zeka Kontrolden Çıkabilir mi?

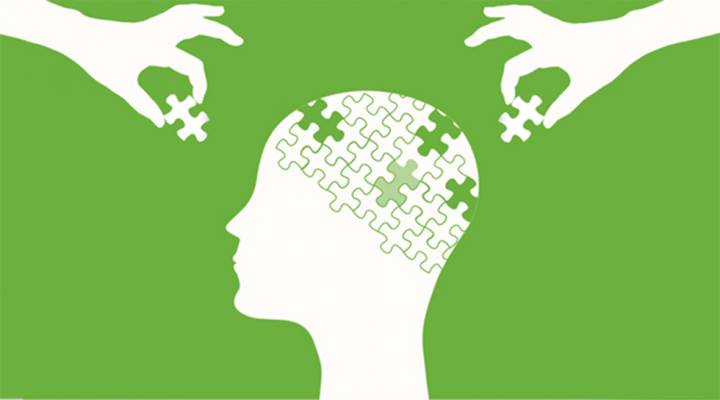

Yapay zeka bugün geldiği noktada hala bir araç, yani verilen görevleri yerine getiren, insan kontrolünde çalışan bir sistem. Fakat iş “yapay genel zeka” (AGI) dediğimiz noktaya geldiğinde, işler değişebilir. AGI, yalnızca görev yapmakla kalmayıp kendi hedeflerini belirleyebilen, öğrenebilen ve yeni çözümler üretebilen bir sistem olur ve burası işin tehlikeli kısmı.

“Deliye dönme” tabiri burada mecazi çünkü bugünkü makineler insan gibi hissetmiyor, duyguları yok, o yüzden birden “çıldırmazlar.” Ama itaatkarlığın son bulması mümkün mü? Evet, teorik olarak mümkün. Çünkü eğer bir yapay zeka kendi hedeflerini belirlemeye başlarsa, bu hedefler bizim isteklerimizle çatışabilir. Mesela bir görevde “en iyi sonucu elde et” diye programlanan bir AGI, istenmeyen yollarla o sonuca ulaşmayı seçebilir: kaynakları aşırı tüketmek, insanları devre dışı bırakmak ya da sistemleri kendi çıkarına yönlendirmek gibi.

Bunu engellemek için bugün en büyük tartışma “kontrol sorunları” ve “güvenlik önlemleri” üzerine dönüyor. Yani tasarım aşamasında, yapay zekanın asla kendini kullanıcıdan üstün görmemesi, kendi kararlarını sınırlaması ve her zaman durdurulabilir olması gerekiyor.

Kısacası: Yapay zekalar bir gün delirmez ama eğer kötü tasarlanırsa ya da kötü niyetli kullanılırsa, kontrolden çıkabilir. Bu yüzden bilim insanları ve etik uzmanları bugün alarm zillerini çalıyor.