Yapay Zekaların hukuki sorumluluğu: Hatalarda Kim Sorumlu Olacak?

Yapay zeka, son yıllarda hayatımızın her alanında gördüğümüz veya görmediğimiz bir şekilde çalışmakta. Sağlık, ulaşım, finans, savunma sanayii gibi önemli sektörlerde kritik kararlarda yer almaya başladı. Ancak yapay zekanın bu hızlı yükselişi bir soruyu akıllara getiriyor: Yapay zeka sistemleri hata yaptığında sorumluluk kime ait olacak? Örnek olarak sağlık sektöründe yanlış teşhis koyarak hastanın hayati tehlikeye girmesi, otonom araçların trafik kazasına sebep olması, üretim konusunda üretimi aksatacak hatalar yapan yapay zekalar. Bunların sorumlusu kim olmalı? Geleneksel hukuk sistemi, sorumlulukları insanlara veyahut kurumlara yüklerken kendi başına öğrenip karar veren yapay zekalarda ne yapılacak? Bu makalede yapay zekaların hatalarında veya sorgulanması gereken durumlarda sorumluluğun kime ait olacağı, bu denklemin nasıl çözülebileceği hakkında konuşacağız.

Yapay Zekada Hata Kavramı: İnsan Hatasından Farkı Ne?

İnsan kaynaklı hatalar genellikle dikkatsizlik, stres, yorgunluk, tedbirsizlik, bilgi eksikliği gibi sebeplerden dolayı yaşanmakta. Bir şoförün uykusuzluktan dolayı kaza yapması, doktorun yorgunluktan dolayı yanlış teşhis koyabilmesi buna örnek olarak verilebilir. Ancak yapay zekada hata çok daha farklı bir zeminde gerçekleşmektedir. Yanlış ya da eksik veri sebebiyle algoritmada oluşabilecek hatalar, eğitildiği veride bulunabilecek önyargılar, veya hiç veri eğitimi almadığı senaryolarla karşılaştığında hatalar ortaya çıkabilir. Buradaki temel fark insan hatasının bireysel dikkat ve deneyimle ilişkili olması, yapay zeka hatasının ise sistemin tasarımı, kullanılan yazılım ve veri setleri ile ilgili olmasıdır.

Hataların telafisi

İnsanlar hata yapmanın olağan bir durum olduğunun farkındadır ve çoğu zaman hata fark edildiğinde bunu düzeltme şansı bulunur. Bir şoför direksiyon hakimiyetini kaybettiğini hissettiğinde öz farkındalık ve sezgisinden dolayı bunu fark eder ve düzeltebilir. Ancak yapay zeka sistemlerinde durum bu şekilde değildir, çünkü algoritma yanlış sonuç üretmeye başladığında kendi çıktısının hatalı olduğunu fark edemez. Sezgi veya öz farkındalık gibi insani duygulara sahip değildir. Sistem, yanlış veriyi doğru olarak işler ve bu yanlışlık diğer çıktıların da hatalı olmasına sebep olur. Burada göz önünde bulundurulması gereken en kritik risk aynı hatayı defalarca ve sistematik bir biçimde tekrarlamasının beklenebileceğidir.

Bu durumun tehlikesi özellikle sağlık, finans ve ulaşım gibi kritik alanlarda çok daha belirgin olur. Sağlıkta yanlış bir teşhisin sürekli tekrar edilmesi bir hastanın hayatına mal olabilir. Finans sektöründe kredi değerlendirme algoritmasının önyargılı verilerden dolayı sürekli yanlış kararlar alması hem bireyleri mağdur eder hem de ekonomik istikrarsızlığa sebep olabilir. Ulaşımda ise bir otonom aracın sensör hatası yüzünden yol işaretlerini yanlış yorumlaması, aynı koşullar tekrarlandığında sürekli aynı kazaya yol açabilir.

Kısacası, insan hatası bireysel ve çoğu zaman tekil olaylarla sınırlıyken, yapay zekâ hatası fark edilmediği sürece zincirleme şekilde tekrarlanır ve sonuçları çok daha geniş kitleleri etkiler. Bu yüzden yapay zekâ sistemleri düzenli insan denetimine muhtaçtır.

Mevcut Hukuki Çerçeve yapay zeka için uygulanabilir mi?

Ülkelerin mevcut hukuk düzenlerinde bir hata veya zarar ortaya çıktığında genellikle üç ihtimal üzerinden sorumlu kişi veya kişiler belirlenir: birey, kurum ya da üretici. Örneğin bir otonom araç kazası yaşandığında şu sorular gündeme gelir: Sorumluluk sürücüde mi, aracı üreten şirkette mi yoksa yazılımı geliştiren ekipte mi? Çoğu ülke, bu olaylarda sorumluluğu ya aracı kullanan kişiye ya da üretici firmaya yüklemeye çalışıyor. Ancak yapay zekâ, kendi başına karar verebilen bir algoritma ile çalıştığı için bu klasik yaklaşım yetersiz kalıyor.

Yapay zekanın mevcut hukuki çerçevede yargılanmasını aksatacak bir diğer sorun da, yapay zekânın kararlarının öngörülemez olması. İnsan davranışları belli normlar ve niyetler üzerinden değerlendirilebilirken, yapay zekâ algoritmaları çok büyük verilerden öğreniyor ve kimi zaman geliştiricilerin bile tahmin edemeyeceği sonuçlar üretebiliyor. Bu durumda “kast” veya “ihmal” gibi klasik hukuk kavramları bulanıklaşıyor.

Bugün için mevcut hukuki çerçeve kısmen uygulanabilir olsa da uzun vadede yeni düzenlemelere ihtiyaç duyulacağı çok açık. Avrupa Birliği’nin “AI Act” girişimi bu yönde atılan önemli adımlardan biri. Ancak küresel ölçekte kabul görecek standartlar oluşmadığı sürece, yapay zekânın neden olduğu zararlarda sorumluluğun kimde olduğu tartışmalı kalmaya devam edecek.

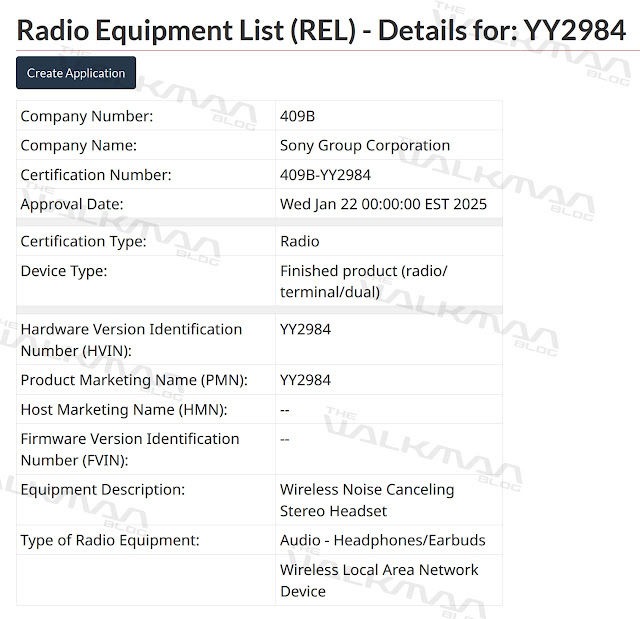

AI Act nedir?

AI Act, yapay zekâ kullanımını yasaklamak yerine düzenlemeyi amaçlayan Avrupa Birliği Komisyonu tarafından sunulmuş ve görüşmelerle geliştirilmiş bir yasadır. Avrupa Birliği’nin insan haklarını, tüketici güvenliğini ve dijital piyasaları düzenleyen mevcut yasalarına dayanıyor ancak yapay zekâya özel ilk çerçeveyi çiziyor. Böylece hem yapay zeka ile yapılan yeniliklerin önü kesilmiyor hem de vatandaşların güvenliği korunmaya devam ediliyor. Özellikle otonom araçlar, sağlık sistemleri ve işe alım süreçlerinde kullanılan yapay zekâ yazılımları bu yasa kapsamındaki en kritik alanlar.

Sorumluluk Paylaşımı: Üretici, Kullanıcı ve Yapay Zeka

Yapay zekâyı tasarlayan ve geliştiren taraf olan üretici, en büyük sorumluluğu üstlenmektedir. Sistemin hangi veri setleriyle eğitildiği, güvenlik önlemlerinin yeterliliği ve algoritmaların nasıl çalıştığı doğrudan üreticiye bağlıdır. Eğer eğitim sürecinde eksik ya da hatalı veriler kullanılırsa ve bu durum bir hataya yol açarsa, ilk sorumluluk üreticide olur.

Kullanıcı da yapay zekâyı nasıl çalıştırdığına göre sorumluluk taşır. Yanlış verilerle sistemi beslemek, onu kapasitesinin dışında zorlamak veya yanlış amaçlarla kullanmak hatanın kaynağı olabilir. Bu yüzden yalnızca yazılımın varlığı değil, kullanıcıların onu hangi koşullarda devreye soktuğu da önemlidir.

Yapay zekânın kendi sorumluluğu konusu ise hâlâ tartışmalıdır. Kendi başına karar alabilmesi, onu hukuken bağımsız bir aktör yapmaz. Yine de ileride yapay zekâya tüzel kişilik verilmesi fikri gündeme gelebilir. Böyle bir adım atılırsa, sistemlerin ürettikleri hatalardan doğrudan sorumlu tutulması söz konusu olabilir.

Etik Boyut: Yapay Zekaya Kendi Kararlarının Hesabını Sorma

Yapay zeka çoğu karar alma mekanizmasında yerini almaya başlamışken akıllara bir soruyu getiriyor. Bir yapay zeka aldığı kararların sonuçlarından “etik” olarak sorumlu tutulabilir mi?

İnsanların sorumluluk sahibi olmalarını sağlayan şey, irade, bilinç ve toplumsal değerleri kavrayabilen, düşünebilen bir canlı olmasıdır. Bunun aksine yapay zeka algoritmalara, veri setlerine ve matematiksel modellere dayanmaktadır. Yani yansıttığı tutum, verdiği kararlar, cevaplar aslında yapay zeka modelini geliştiren kişilerin düşünceleridir. Geliştiriciler tarafından yapay zekaya sunulan ve kullanılan verilerin kalitesi de kullanıcıların yönlendirmeleriyle şekillenir. Bu açıdan bakıldığında, yapay zekaya kendi kararlarının hesabını sormak felsefi açıdan mantıklı değildir. Çünkü ortada hesap sorulabilecek bir “özne” mevcut değildir. Çoğu yapay zeka sistemlerinin tek bir kaynaktan değil, internet kullanan herkesin fikirlerine göre düşünen, karar alan bir yapı olduğu bilinmelidir. Bu da yapay zekanın düşünmesinin tek bir kişiye indirgenerek özne haline getirilememesine sebep olur.

Sonuç olarak, yapay zekâya hesap sormak yerine asıl tartışılması gereken nokta, bu sistemleri tasarlayan ve kullanan insanların etik sınırları nasıl çizeceğidir. Şeffaf algoritmalar, denetlenebilir süreçler ve açık sorumluluk paylaşımları olmadan, yapay zekânın tek başına “hesap verebilir” hale gelmesi şimdilik bir yanılsamadan öteye geçmemektedir.

Uluslararası Yaklaşımlar: AB, ABD ve Diğer Ülkelerde Durum

Yapay zekaya ilişkin hukuki düzenlemeler ülkeden ülkeye farklılık gösteriyor. Teknolojinin hızına yetişmekte zorlanan devletler, kendi önceliklerine göre farklı çerçeveler oluşturmuş durumda.

Avrupa Birliği, bu alanda en kapsamlı adımı atan aktörlerden biri oldu. “AI Act” adı verilen yasa tasarısı, yapay zekayı yasaklamak yerine risk temelli bir yaklaşımla düzenlemeyi amaçlıyor. Makalede önceden bahsettiğimiz üzere yüksek riskli kabul edilen sağlık, ulaşım ve güvenlik uygulamalarında sıkı kurallar getirirken, düşük riskli alanlarda esnek bir çerçeve sunuyor. Böylece hem vatandaşların güvenliği korunuyor hem de yeniliğin önü kapanmıyor.

Amerika Birleşik Devletleri ise daha serbest bir yol izliyor. Federal düzeyde bağlayıcı bir yasa henüz yok. Ancak Beyaz Saray’ın yayımladığı “AI Bill of Rights” (Yapay Zeka Haklar Bildirgesi) bireylerin korunmasına yönelik ilkeleri belirliyor. Bunun yanında, eyaletler kendi düzenlemelerini de çıkartabiliyor. ABD’nin yaklaşımı, inovasyonu teşvik etmeyi önceleyen ancak güvenlik ve etik konularını sektörel yönergelerle çözmeye çalışan daha parçalı bir yapıya sahip.

Diğer ülkeler de kendi yollarını çiziyor. Çin, yapay zeka üzerinde daha sıkı bir denetim uyguluyor. Özellikle içerik üretiminde kullanılan algoritmalara devletin doğrudan müdahale hakkı bulunuyor. Japonya ise daha esnek bir tutumla yapay zekayı ekonomik büyümenin motoru olarak görüyor ve inovasyonu destekleyici adımlar atıyor. Türkiye’de ise henüz kapsamlı bir yapay zeka yasası bulunmamakla birlikte, ulusal strateji belgeleri ve etik rehberler üzerinden yönlendirme yapılıyor.

Genel tabloya bakıldığında, her ülkenin kendi sosyo-ekonomik önceliklerine göre hareket ettiği görülüyor. Ancak küresel ölçekte ortak bir standart henüz oluşmuş değil. Bu da yapay zekanın sınır tanımayan yapısı göz önüne alındığında, ilerleyen yıllarda uluslararası iş birliğinin kaçınılmaz hale geleceğini gösteriyor.

Geleceğe Bakış: Yapay Zeka İçin Yeni Hukuki Düzenlemeler

Gelecekte yapay zeka sistemlerinin şeffaflığı ve hesap verebilirliği konusunda daha katı yükümlülükler getirilmesi gerekmektedir. “Kara kutu” şeklinde çalışan, kararlarını açıklayamayan algoritmalar yerine, gerekçelerini izah edebilen ve denetlenebilir sistemler ön plana çıkacak. Bu da hem etik hem de hukuki açıdan güveni artıracaktır.

Gelecekte Birleşmiş Milletler veya OECD gibi kuruluşların öncülüğünde, yapay zekaya dair ortak prensiplerin belirlenmesi ve ülkelerin bu standartları benimsemesi olası görünüyor.

Kısacası, yapay zeka için yeni hukuki düzenlemeler yalnızca teknolojiyi değil, aynı zamanda toplumun güvenlik, etik ve adalet beklentilerini de karşılayacak şekilde tasarlanmak zorunda. Bu dönüşüm, hukukun teknolojiye uyum sağlama hızını da ciddi bir sınavdan geçirecek.

Sonuç: Yapay Zekanın Sorumluluğunu Kim Üstlenecek?

Yapay zekanın sorumluluğu tartışmalarında en güçlü ve uygulanabilir çözüm, yükün öncelikli olarak üretici ve kullanıcıya ait olmasıdır. Çünkü yapay zeka henüz bağımsız bir hukuki özne değildir ve kendi kararlarının hesabını veremez. Bir sistemin nasıl eğitildiği, hangi güvenlik önlemlerinin alındığı üreticinin sorumluluğudur. Aynı şekilde bu sistemin doğru, etik ve sınırları dâhilinde kullanılması da kullanıcıya aittir.

Gelecekte yapay zekaya tüzel kişilik tanınması ihtimali otoriteler ve insanlar arasında tartışılabilir. Bugünkü şartlarda sorumluluk zincirinin merkezinde insan ve kurumlar vardır. Dolayısıyla hatalı çıktılar, yanlış kararlar veya doğan zararlar karşısında hesap sorulacak merci yapay zekânın kendisi değil, onu geliştiren ve kullanan taraflardır.