Çin’in bedava ChatGPT rakibi Qwen3-Next yayınlandı!

Alibaba’nın Qwen araştırma ekibi açık kaynaklı büyük dil modeli serisini yeni Qwen3-Next ile genişletti. Ekip yaz boyunca farklı modellerin duyurusunu yaptıktan sonra bu kez performans ve verimliliği bir arada sunan hibrit bir mimariyle geldi. Qwen3-Next yalnızca 3 milyar aktif parametre kullanmasına rağmen 80 milyar parametreli yapıya sahip ve uzun bağlamlarda yüksek verimlilikle çalışıyor.

Alibaba tamamen ücretsiz Qwen3-Next yapay zekasını kullanıma sundu

Qwen3-Next iki varyantla kullanıma sunuldu. Bunlar Instruct ve Thinking. Her ikisi de Apache 2.0 lisansı altında dağıtılıyor ve Hugging Face, ModelScope, Kaggle ile Alibaba Cloud üzerinden erişime açık. Ayrıca Qwen Chat platformunda doğrudan kullanılabiliyor. Yeni modelde Gated DeltaNet ve Gated Attention yaklaşımları birlikte uygulanıyor. DeltaNet katmanları uzun metinlerde hızlı okuma işlevi görürken Gated Attention katmanları detaylı ve hassas kontrol sağlıyor. Bu hibrit yaklaşım hem hız hem doğruluk avantajını tek modelde birleştiriyor.

Qwen3-Next Mixture-of-Experts yapısında da önemli yenilikler getiriyor. Uzman sayısı 128’den 512’ye çıkarıldı ve yalnızca 10 yönlendirilmiş uzman ile bir paylaşımlı uzman aynı anda etkinleştiriliyor. Bu yapı işlem maliyetlerini azaltırken modelin kararlılığını da güçlendiriyor. Zero-Centered RMSNorm ve normalize edilmiş router kullanımı büyük ölçekli eğitim süreçlerinde istikrarlı sonuçlar sağlıyor.

Teknik açıdan en dikkat çeken unsurlardan biri de belirttiğimiz gibi modelin yalnızca 3 milyar aktif parametreyle çalışması. Böylece 15 trilyon token üzerinde eğitilen model selefi Qwen3-32B’den çok daha düşük donanım maliyetiyle eğitildi ve çalıştırıldı. Uzun bağlam testlerinde ise 32.000 token ve üzerinde 10 kata kadar daha yüksek hız sunuyor. Qwen3-Next doğal olarak 256.000 token bağlam penceresini destekliyor ve RoPE ölçekleme yöntemleriyle 1 milyon token uzunluğa kadar doğrulandı.

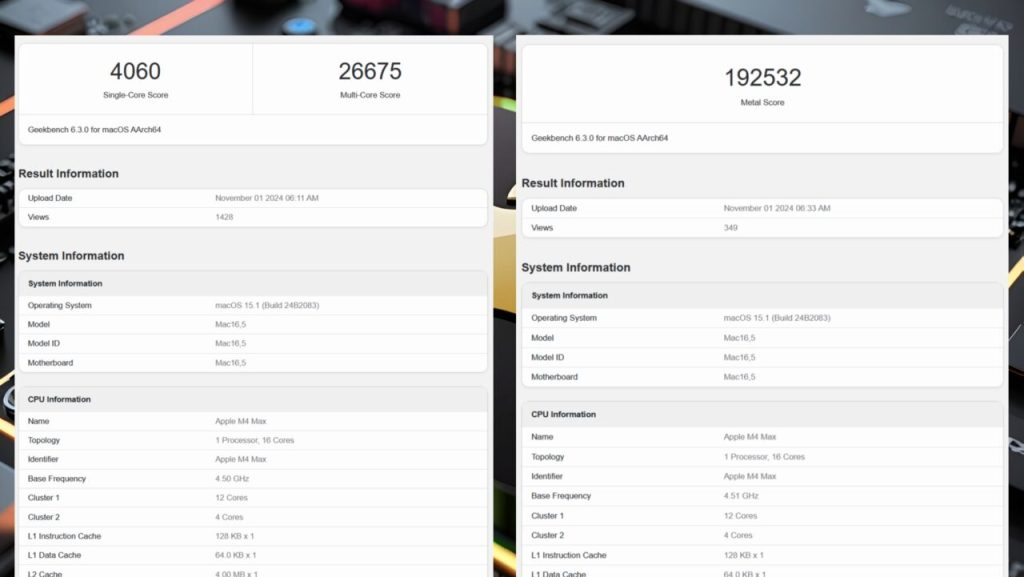

Performans testlerinde Qwen3-32B’nin üzerinde sonuçlar elde etti. Reasoning odaklı Thinking varyantı Gemini-2.5-Flash-Thinking gibi kapalı kaynaklı modellere karşı üstünlük sağladı. Instruct modeli ise Qwen3’ün 235 milyar parametreli amiral gemisine yakın uzun bağlam performansı sundu. Üçüncü taraf test kuruluşu Artificial Analysis ise Qwen3-Next’in reasoning varyantına 54 puan vererek onu DeepSeek V3.1 Reasoning modeliyle aynı seviyeye koydu. Non-reasoning varyantı ise 45 puan aldı.

Modelin text-only olması multimodal kabiliyetleri sınırlasa da 80 milyar parametreli FP8 formatıyla tek bir Nvidia H200 GPU üzerinde çalışabilmesi önemli bir avantaj. Qwen3-Next Apache 2.0 lisansı sayesinde ticari kullanım için de serbestçe uyarlanabiliyor. Hugging Face Transformers entegrasyonu ve OpenAI uyumlu API desteği de geliştiriciler için erişilebilirliği artırıyor.

Qwen ekibi Qwen3-Next’in hem ölçeklenebilir hem de maliyet açısından uygun bir çözüm sunduğunu vurgularken serinin bir sonraki adımı olan Qwen3.5 üzerinde çalıştıklarını da açıkladı. Yeni mimariyle uzun bağlamlarda daha güçlü, hızlı ve ekonomik açık kaynaklı modellerin pazara sunulması bekleniyor.