Yapay zekada “context window” nedir?

Evet, grafik yongaları, donanımlar ve yapay zeka platformları ışık hızında gelişiyor. Ancak hangisi olursa olsun, her yapay zekanın, her büyük dil modelinin belirli bir kapasitesi var. Büyük miktarda metni komut istemine kopyalayıp yapıştırdığınızda, izin verilen kapasiteyi aştığınıza dair bildirimler alabilirsiniz. Bu nedenle “context windows” dediğimiz şey AI evreninde büyük önem taşımakta.

Context window nedir?

Context window yani bağlam penceresi, kullandığınız yapay zeka platformlarının bağlı olduğu büyük dil modellerinin (LLM) kapasitesiyle doğrudan bağlantılı. Bazen context length (bağlam uzunluğu) şeklinde de bir terim duyabilirsiniz, ikisi de aynı şey.

Context windows veya context length, yapay zeka modelinin bir anda işleyebileceği ve hatırlayabileceği maksimum bilgi miktarını ifade ediyor. Bu miktar “token” adı verilen birimlerle ölçülmekte. Başka bir deyişle çalışma belleği olarak tanımlayabileceğimiz bağlam uzunluğu, modelin kısa süreli hafızası gibi. Daha geniş boyutlu bağlam penceresi, modelin daha uzun diyalogları sürdürmesini, daha büyük belgeleri işlemesini ve daha tutarlı, doğru yanıtlar üretmesini sağlıyor.

Eğer LLM’nin kapasitesi büyükse, model herhangi bir anda çok daha fazla veriyi dikkate alabilir ve işlem süresi boyunca sağlanan daha büyük veriyi hatırlayabilir. Daha büyük bir bağlam penceresi, bir yapay zeka modelinin daha uzun girdileri işlemesini ve her çıktıya daha fazla bilgi eklemesini sağlar.

Yapay zeka sohbet robotlarını birçoğunuz kullanmışsınızdır. Bazen tıpkı biriyle sohbet eder gibi konuşma uzar gider. Bağlam uzunluğu, daha önceki mesajlardaki ayrıntıları unutmadan ne kadar uzun bir konuşma yapabileceğinizi belirliyor. Bunun yanında, aynı anda işleyebileceği maksimum belge veya kod örneği boyutuyla da doğrudan bağlantılı. Bir komut istemi, konuşma, belge veya kod tabanı yapay zeka modelinin bağlam penceresini aştığında, modelin yoluna devam edebilmesi için kesilmesi veya özetlenmesi gerekmekte.

Genel olarak, bağlam penceresi boyutunu artırmak daha fazla doğruluk, daha az halüsinasyon, daha tutarlı model yanıtları, daha uzun konuşmalar ve daha uzun veri dizilerini analiz etme becerisi demek. Öte taraftan bağlam uzunluğunun artırılması bazı dezavantajları da beraberinde getiriyor. Daha geniş bağlam uzunluğu için daha fazla hesaplama gücü gerekiyor, bu da doğrudan maliyet artışı anlamına geliyor. Diğer yandan, çok fazla veri işlenmesi nedeniyle yapay zekanın kafasının karışmasına neden olabiliyor.

Token nedir?

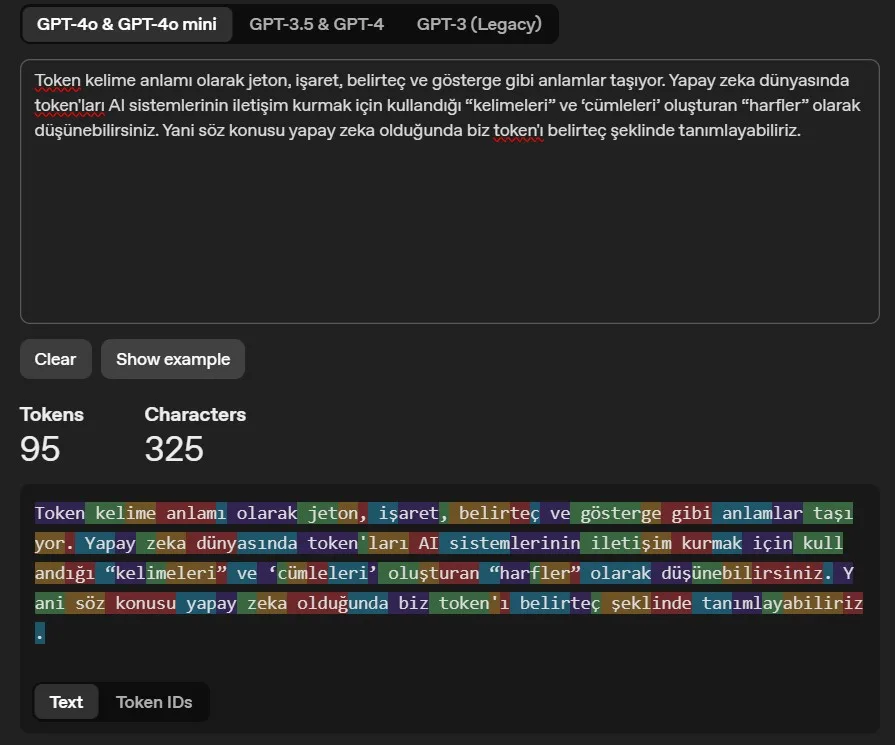

Token ve context windows birbiriyle iç içe olan terimler. Token kelime anlamı olarak jeton, işaret, belirteç ve gösterge gibi anlamlar taşıyor. Yapay zeka dünyasında token’ları AI sistemlerinin iletişim kurmak için kullandığı “kelimeleri” ve ‘cümleleri’ oluşturan “harfler” olarak düşünebilirsiniz. Yani söz konusu yapay zeka olduğunda biz token’ı belirteç şeklinde tanımlayabiliriz.

Token’lar, makine öğrenimi modeline beslenen ve bu model tarafından üretilen metin bölümleridir. Metin bölümleri tek tek karakterler, tam kelimeler, cümleler, kelimelerin parçaları veya daha büyük metin parçaları olabilir.

- 1 token ≈ İngilizce’de 4 karakter

- 1 token ≈ kelimelerin ¾’ü

- 100 token ≈ 75 kelime

Genel bir kural olarak, bir token genellikle yaygın İngilizce metinlerde ~4 karakterlik metne karşılık gelir. Bu da yaklaşık olarak bir kelimenin ¾’üne denk düşüyor: 100 token ~= 75 kelime. Aşağıdan Open’AI’ın Tokenizer adını verdini hesaplama aracıyla sağlanan örneğe göz atabilirsiniz:

Context windows ve token arasındaki ilişki

Token’lar, AI modellerinde metnin yapı taşlarıdır diyebiliriz. Biraz önce de değindiğimiz gibi, token bir kelime, kelimenin bir parçası veya noktalama işareti olabilir. Bağlam penceresi ise bir modelin aynı anda kaç token işleyebileceğini belirler. Örneğin 3000 tokenlik bağlam penceresine sahip bir model, tek bir geçişte 3000 token işleyebilir ve bu sınırın üzerindeki metinler yok sayılır.

Büyük boyutlu bağlam penceresi, yapay zekanın daha fazla token işlemesine olanak tanıyarak uzun girdiler için anlama ve yanıt oluşturma becerisini geliştirmekte. Tabiri caizse, kapasite genişledikçe yapay zeka sisteminin perspektifi de genişler. Daha küçük bir pencere, daha dar bir bakışı gibi. Yapay zeka modellerinin bağlamı koruma yeteneğini sınırlayarak çıktı kalitesini (verilen cevaplar) doğrudan etkiler.

Özetle context window, LLM’nin girdi komutunu (sorduğunuz soru vb.) ve çıktıyı (üretilen yanıt) takip etmek için kullandığı şeydir. Büyük dil modelleri genellikle uzunluğunun büyüklüğü konusunda token cinsinden belirtilen bir sınıra sahip. Genel olarak bağlam penceresi ne kadar büyükse o kadar iyidir, çünkü LLM yapmaya çalıştığı iş hakkında daha fazla “bağlam” işleyebilir.

Bağlam penceresi neden önemli?

Her şeyden önce, büyük dil modellerinin performansını değerlendirmek için önemli bir faktör. Yüksek token ve context windows sınırlaması, daha yüksek zeka seviyesi ve daha büyük veri işleme kapasitesi demek. Günümüzde tüm teknoloji severler sürekli olarak yapay zeka ile etkileşime giriyor. Kullanıcılar her saniye etkileşimde olduğu yapay zeka platformlarının verdiği yanıtları görüyor. Yeni modeller kullanıma sunuldukça kullanıcılardan gelen tepkiler genellikle aynı yönde oluyor.

Bağlam pencereleri, akıllı yapay zeka yanıtları için metin sınırları belirleyerek uzun yanıtları önlerken okunabilir bir dilde tutarlı metinler üretilmesini sağlıyor. Geniş kapasiteli yapay zekaların avantajlarını kısaca ele alacak olursak:

- Zaman tasarrufu: Üretken AI araçları, hedef token’ın her iki yanındaki veri kümelerini belirleyerek girdi hedef token’ı ile ilgisiz verileri önler. İyi tanımlanmış bir bağlam penceresi, özellikle de daha geniş bir bağlam penceresi işlemleri hızlandırabilir. Geniş bağlam imkanı, verileri daha küçük parçalara ayırma ihtiyacını azaltarak süreci hızlandırıyor. Girişleri bölümlere ayırmak yerine, modeller her şeyi tek seferde işleyebilir, özetleme ve sınıflandırma gibi görevleri kolaylaştırıyor.

- Karmaşık ve uzun girdiler, daha iyi yanıtlar: Büyük bir bağlam penceresi, LLM’lerin token’ları yönetme konusundaki anlamsal yeteneğinin güçlü bir göstergesi. Büyük dil modelleri, kelime gömme tekniği kullanarak vektör veritabanında dilbilimsel aramaları destekleyebilir ve nihayetinde hedef token ile ilgili terimleri anlayarak alakalı yanıtlar üretebilir. Geniş bağlam pencereleri, modellerin tutarlılığı kaybetmeden karmaşık ve uzun belgeleri işlemelerini kolaylaştırmakta. Bu, sürekli bilgi akışının korunmasının önemli olduğu yasal metinler, araştırma makaleleri veya transkriptler için özellikle yararlı.

- Ayrıntılı analiz: Bağlam uzunluğu, verileri derinlemesine analiz etmek için hedef token’ın solunda ve sağında çalışır. Önem puanlarının yerleştirilmesi, tüm belgenin özetlenmesini sağlamakta. Birçok token’ın incelenmesi, araştırma, öğrenme ve AI tabanlı kurumsal işlemleri hızlandırabilir.

- Token ayarlaması, esnek tahsis düzeyi: LLM’lerdeki kodlayıcı ve kod çözücü, bağlamsal bağımlılıkları daha iyi anlamak için “dikkat başlıkları” gibi mekanizmalar kullanıyor. Bağlam uzunluğu yüksek olan örneklerde, bir LLM gereksiz yanıtları önlemek için hedef token’ın ilgili tarafına seçici olarak odaklanabilir. Token kullanımının optimizasyonu, uzun metinlerin hızlı bir şekilde işlenmesini sağlarken aynı zamanda metnin alaka düzeyini belirler ve korur. Eğer bağlam uzunluğu geniş ise, modellere sağlanan token tahsisinde daha fazla esneklik elde edilebilir ve önemli ayrıntılar kaçırılmadan yakalanabilir. Sonuç olarak, daha dengeli ve doğru çıktılar sağlanıyor.

- Gelişmiş analitik yetenekler: Geniş bağlam pencereleri, uzak token’lar arasındaki ilişkiyi anlayarak daha derin ve ayrıntılı analizler yapılmasını sağlıyor. Bu da duygu analizi veya karmaşık bilgilerin özetlenmesi gibi incelikli anlayış gerektiren görevler için çok önemli.

Büyük yapay zeka örnekleri

Hepinizin yakından tanıdığı büyük dil modellerinin farklı bağlam uzunlukları var. Birkaç örneğe göz atacak olursak:

- GPT-3: Generative Pre-trained Transformer (GPT), bildiğiniz gibi en popüler büyük dil modellerinden. Eylül 2021’e kadar eğitilen GPT-3’ün bağlam penceresi boyutu 2049 token idi.

- GPT-3.5-turbo: OpenAI GPT-3.5-turbo 4.097 token’lık bir bağlam penceresine sahipti. Başka bir sürüm olan GPT-3.5-16k, daha fazla sayıda token işleyebilirdu: 16.385 token sınırı.

- GPT-4: İnce ayar yeteneğine sahip GPT-4, 8.192 token’a kadar bağlam pencere boyutu sunuyor. GPT-4-32k, 32.768 token’a varan çok daha geniş kapasitelere erişebiliyor.

- Llama: İlk Llama modellerinin maksimum bağlam uzunluğu 2.048 token idi.

- Llama 2: Bu değer Llama 2 ile 4.096 token’a iki katına çıkarıldı.

- Llama 3: Nisan 2024’teki lansmanda, Llama 3 modelinin yaklaşık 8.000 token ile üstün performans sunduğu açıklandı.

- Llama 3.1: 128.000 token uzunluğunda bağlam pencereleri sunan Llama 3.1 modellerinin piyasaya sürülmesiyle sınır çok ciddi şekilde arttı.

- Llama 3.2: 3.2 modellerinde maksimum bağlam uzunluğu 128.000 token.

- Claude: Anthropic’in AI aracı Claude, yaklaşık 9.000 token sınırıyla kullanıma sunulmuştu.

- Claude 2: Anthropic, Claude 2’nin 100.000 token’a kadar daha büyük bir bağlam penceresi sunduğunu duyurdu. Kullanıcılar, Claude 2 API için tek bir komut satırına yaklaşık 75.000 kelimelik bir belgenin tamamını girebiliyor.

- Claude 3.5 Sonnet: Son nesil modellerden 3.5 Sonnet, yaklaşık 200.000 tokenlik standart bir bağlam penceresiyle ön plana çıkıyor. 2024 yılının Eylül ayı başında Anthropic, yeni “Claude Enterprise” planı aracılığıyla erişilen modellerin 500.000 tokenlik genişletilmiş bir bağlam penceresi sunacağını duyurmuştu.

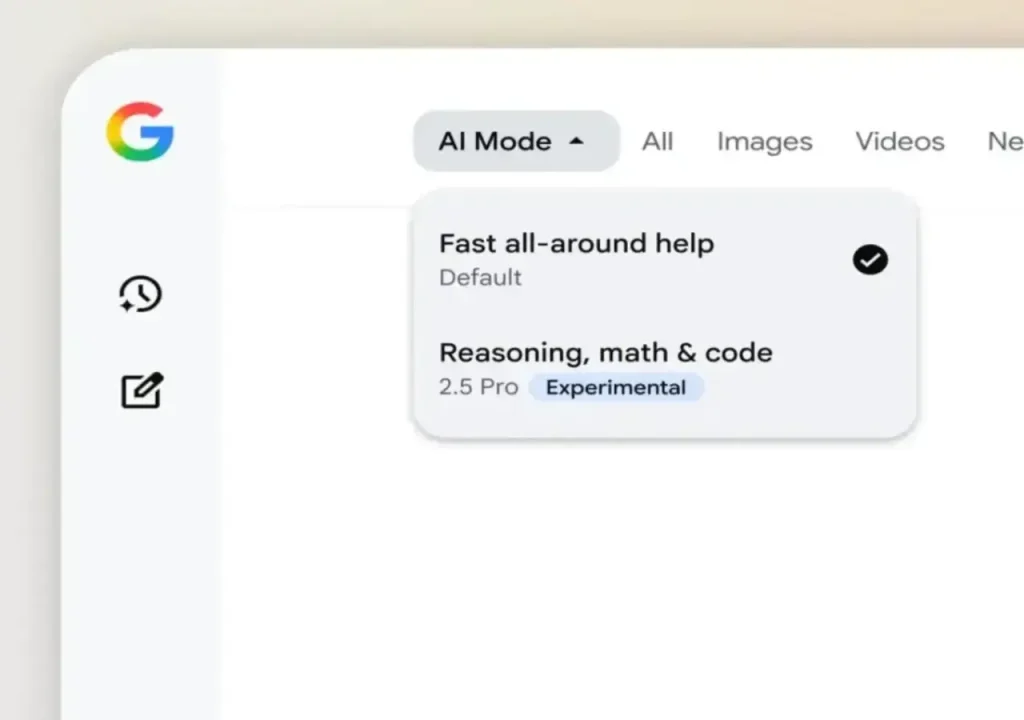

- Google Gemini 1.5 Pro: Google’ın Gemini serisi modelleri, ticari dil modelleri arasında en büyük bağlam penceresine sahip seçenekleri barındırıyor. Google’ın amiral gemisi modeli olan Gemini 1.5 Pro, 2 milyon token’a kadar bağlam uzunluğuyla devasa seviyede.

- Gemini 1.5 Flash: 1.5 Flash gibi diğer Gemini 1.5 modelleri ise 1 milyon token’lık bir bağlam penceresiyle yine üst seviyede.